UX DAYS TOKYO 2019 レポ「音声ユーザーインターフェースデザイン」

2019年4月5日(金)、UX DAYS TOKYO 2019 がスタートしました。

本日行われたカンファレンスでは、VUI に関するセッションがあったので、そちらをレポートしたいと思います!

Contents

UX DAYS TOKYO とは

アジア最大級のUXのカンファレンス(らしい)。

主催は、Web Directions East合同会社。

UX DAYS TOKYO 2019

2019年4月5日(金)〜4月7日(日)開催

カンファレンス:2019年4月5日(金) @大崎ブライトコア

ワークショップ:2019年4月6日(土)〜4月7日(日)開催 @品川インターシティ

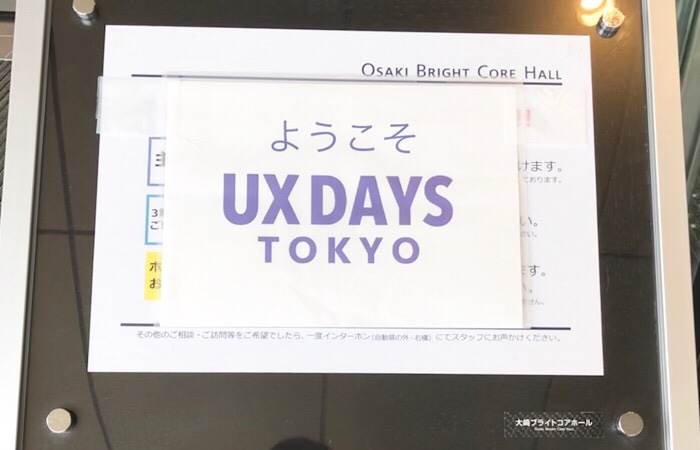

ちなみに、参加費がちょー高い。

カンファレンスが5万円弱。ワークショップが8万円。

参加者全員に配られる品々の中に、ワイヤレスモバイルバッテリーが含まれていることに驚きwww

セッション詳細

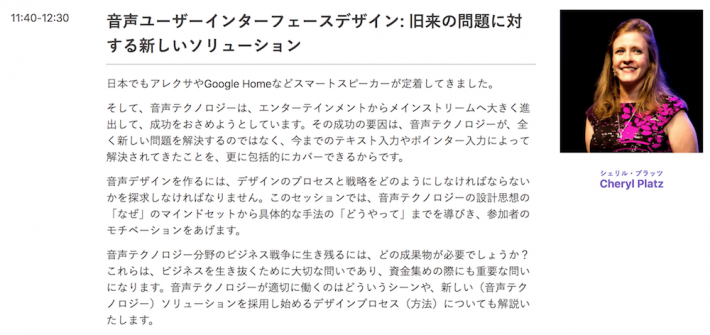

音声ユーザーインターフェースデザイン: 旧来の問題に対する新しいソリューション

VUIは他のデバイスが既に解決した問題を代替している

VUIのコンテンツは、スマホなど、既に他のデバイスが解決していたことを代替していることが多いとのこと。

USで一番人気のタスクは、タイマーや音楽、アラーム、検索など、非常に一般的。

ただ違うのは、質問を音声で行うことと、回答を音声で返すことだけ。

VUI の歴史

現在、私たちは当たり前のようにスマホやPCを使っていますが、それらを使えるようになるまでに、多少使い方を練習しているはずです。

例えばフリック入力とか、ブライドタッチとか…ブラウザで検索したり、写真を加工できるようになったのも、決してモノを初めて手にした日から出来たわけではないはず。

一方、VUI はそんな学習がほとんどいらないというのが特徴だと。

つまりは、会話術という、最初に習得する基礎能力を使うだけでいいということ。

そんなVUIの歴史は、遡ると、実は1952年から始まっていたらしい。

1952年、数字を認識

1952年に、世界で初めて、数字を音声で認識する機械が生まれました。ただ、0から9までの10の数字のみ。これだけでもすごいことでした。

1972年、会話を認識

1976年、約20年後に、ようやく1000の言葉を認識できる機械が誕生。

会話の認識はそれだけ難しいものだということが、20年もかかったという年数からわかります。

ただ、まだこの頃の機械は、認識に数秒必要でした。

200〜400mmsec で理解できる人間にとっては、その2〜3秒ですら長いと感じてしまう。

この秒数が、当時の演算能力の限界だったそうです。

1990s、Dragon NaturallySpeaking 誕生

Dragon NaturallySpeaking という音声認識ソフトウェアが出てきたのがこの頃。

ただ、まだこの頃は音としての認識しかできなかったので、文法のニュアンスやシンタックスの理解ができなかったらしい。

そして、2008年の Google 音声検索

この登場で、VUIの流れが変わった、というほどのもの。

Google が音声検索を出したことによって、ユーザは自分の言葉で話せるようになりました。

今までは機械に合わせた言葉だったので、どう話さないといけないかという、学習が必要でしたが、それがいらなくなった、というのが画期的。

VUI が素晴らしい理由

トレーニングが不要

前述の通り、基礎能力である会話術を使うものだから

ロボットらしさが少なくなる

様々な言葉のゆらぎ、言い方、言葉の順序にも対応できるため、滞りない普通の会話ができるから

注意を奪われない

スマホだと、画面に視線を奪われてしまいますが、VUI だと、周りに注意を向けることが出来ます。

だから、料理中のタイマーとかに適しているんですね。

高齢者に人気

会話相手になってくれる

UI に恐怖がない

誰もが知ってる、自然言語だから。

ただ、日本人は周囲の目を気にしたりとか、変に自分を客観視しちゃって、恥ずかしいとか思っちゃう人、多いでしょうね。

障害のあるユーザでも使える

手を怪我している人や、目が見えない方でも使えるもの。

だから、GUI よりもマーケットが広いのでは?ということ。

新しい顧客を獲得できる

前述の通り高齢者、障害者でも使えるから。

VUI が必要な理由を会社で説得するには?

一部のユーザを阻害してしまう可能性を話す

障害者だけでなく、手がふさがっている料理中の人や運転中の人など、一部ユーザには GUI が使えない場面が発生します。

「例えば、こんな時ね」って、その様子をユーザーストーリーで描いて説得するのが効果的。

VUIマーケットの展望を話す

VUI市場は、どんどん膨らんでいるとのこと。ここをデータをあわせて見せられるといい。

実際は、セッションで提示していたデータから、未来までちゃんと継続的に増えていくのか、というのは疑問に思ったが、少なくとも私はそう望んでいるし、その可能性を信じている。

利用シナリオを作る

VUI がどんな時に生きるのか、どんな場面で使われるのかをストーリーボードにして、関係者に明確に伝わるようにする。

1つ目のユーザーストーリーとは、ユーザーの対象が異なり、こちらは一般ユーザーの一般的な使われ方を示すものだと理解。

VUI 設計するときの基本コンセプト

これは、Alexa スキル開発をされている方なら、余裕のよっちゃんでしょう(古い)

発話(Utterance)

ユーザが話す言葉が真であり、それに合わせていく必要がある。

意図(Intent)

Alexa で言うと、以下のようなインテントというものが存在しますよね。

・「はい」と肯定する場合:YesIntent

・「いいえ」と否定する場合:NoIntent

・「次へ」進む場合:NextIntent

そんな感じで「この発話だと、何を意図しているのか」を定義し、どんな反応をすればいいかを判断するために必要なもの。

プロンプト(Prompt)

システム側の回答の設計。

音声で読み上げてもいいし、画面に表示してもいい。

文法(Grammer)

AI 構築のもととなる部分。

Alexa の場合は、amazon さんが提供してくれてる部分という理解。

VUI の検討で大事なこと

ハッピーパス(Happy Path)

うまくいったらこう流れるよね!という、ベストケースのシナリオを考えること。

失敗した時の対応

VUI を設計する際に考えることの 80% は、失敗になりうるコンテキストを考えることだ、とおっしゃっていました。

例えば、「カリブの海賊を play して」と言われた時。

可能性としては、「ムービーの再生」と「音楽の再生」、そして「上映時間の検索」が考えられる。

確率としては、ムービーが一番高い。

しかし、相手が画面なしデバイスならば、ムービーではありえない。

そんなふうに、あらゆる情報を元に、確率を割り出して、どう反応するかを選んでいく。

社会的インターアクション

「話しかけられたら、機械といえど、人間が話しているように感じてしまう」ということが、学術的に示されているらしい。

参考:Wired for Speech![]()

Alexa の声がデフォルトで女性なのは、女性の声の方が安心感や信頼感が得やすいから、なのではなかろうか。

まとめ

以上、こんな感じでした。

初歩的なお話が多かったですが、VUI の歴史はちゃんと知らなかったので、とても面白かったです。

最新情報をお届けします

Twitter でaoxaをフォローしよう!

Follow @a093_jp